یادگیری تقویتی روی داده های پیش از آموزش RLPT

یادگیری تقویتی چیست؟

برای درک بهتر RLPT، اول باید بدانیم یادگیری تقویتی چیست. در سادهترین تعریف، یادگیری تقویتی یک روش در یادگیری ماشین است که در آن یک عامل (Agent) از طریق آزمون و خطا یاد میگیرد چگونه بهترین تصمیمها را بگیرد.

مثال ساده: فرض کنید یک ربات در یک اتاق قرار دارد و باید راه خروج را پیدا کند. ربات حرکتهای مختلفی امتحان میکند و هر بار که به در نزدیکتر میشود، یک پاداش (Reward) دریافت میکند. اگر اشتباه برود، جریمه میشود. به این ترتیب، ربات به مرور یاد میگیرد کدام مسیر بهینه است.

این همان چیزی است که در الگوریتمهای یادگیری تقویتی اتفاق میافتد: یک سیستم با آزمون و خطا و دریافت بازخورد به تدریج عملکرد خود را بهبود میدهد.

چرا یادگیری تقویتی پیش آموزش مهم است؟

در سالهای اخیر، مدلهای زبان بسیار بزرگی به وجود آمدهاند که به آنها مدل زبان یادگیری بزرگ یا LLM گفته میشود. این مدلها مانند ChatGPT میتوانند متن تولید کنند، سؤال پاسخ دهند و حتی پیشبینیهای هوشمندانه داشته باشند.

اما یک مشکل وجود دارد: این مدلها به حجم عظیمی از دادههای متنی باکیفیت نیاز دارند. رشد این دادهها محدود است، در حالی که توان محاسباتی روزبهروز بیشتر میشود. اینجا است که یادگیری تقویتی پیش آموزش (RLPT) وارد عمل میشود.

به جای اینکه تنها به دادههای برچسبخورده یا نظارت انسانی متکی باشیم، RLPT از خودِ دادههای پیشآموزش بهعنوان منبع یادگیری استفاده میکند. این روش هم بهینهسازی مدل را ممکن میسازد و هم باعث میشود مدل بتواند مسیرهای استدلالی عمیقتر و متنوعتری کشف کند.

برای سادهسازی میتوان گفت در RLPT، متنهای طولانی به بخشهای کوچکتر (مثلاً جملهها) تقسیم میشوند. مدل وظیفه دارد بخش بعدی متن را پیشبینی کند. هر زمان که پیشبینی درست باشد، یک پاداش دریافت میکند.

این فرآیند دو مرحلهی اصلی دارد:

- یادگیری با نظارت شده (Cold Start):

در ابتدا، مدل با استفاده از روشهای سنتی یادگیری ماشین نظارت شده آموزش داده میشود تا حداقل بتواند دستورالعملها را بفهمد.

- یادگیری تقویتی پیش آموزش (RLPT):

پس از آن، مدل با روشهای یادگیری تقویتی بهطور خودکار دادههای پیشآموزش را بررسی میکند و با آزمون و خطا یاد میگیرد چگونه پیشبینیهای بهتری انجام دهد.

این روش باعث میشود مدلها هوشمندتر شوند، بدون اینکه نیازی به صرف هزاران ساعت زمان انسان برای برچسبگذاری دادهها داشته باشیم.

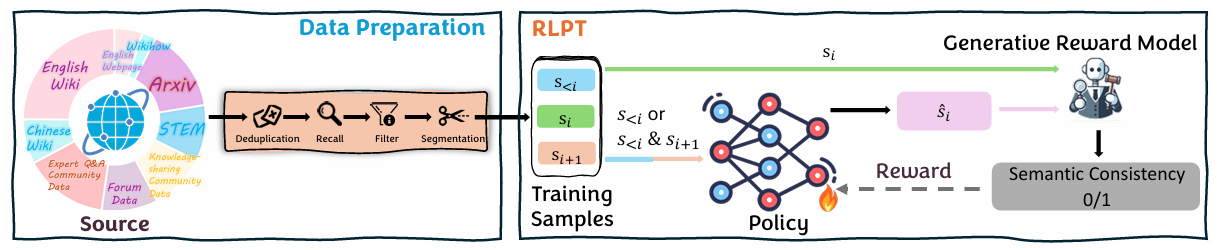

شکل1: مرور کلی RLPT: داده های خام از پیکره های اینترنتی به نمونه های آموزشی (s<i, si, si+1) پردازش میشوند. در طول مرحله پیش آموزش تقویتی LLM سیاست si را مشروط به (ASR) s<i یا روی (MSR) (s<i , si+1) پیش بینی میکند. سپس پیش بینی با si مقایسه میشود تا پاداش محاسبه شود.

مزایای یادگیری تقویتی پیش آموزش

۱. عدم وابستگی به دادههای برچسبخورده

یکی از بزرگترین مشکلات در پژوهشهای یادگیری ماشین این است که دادههای برچسبخورده کمیاب و گران هستند. RLPT این مشکل را حل میکند.

۲. بهبود مهارتهای استدلالی

مدلهایی که با RLPT آموزش میبینند، بهتر میتوانند در موقعیتهای پیچیده تصمیمگیری کنند و حتی در حل مسائل ریاضی عملکرد بهتری نشان دهند.

۳. مقیاسپذیری بالا

با توجه به اینکه روش یادگیری تقویتی پیش آموزش بر پایهی دادههای پیشآموزش موجود است، میتوان آن را بهراحتی روی مدلهای بزرگتر هم پیادهسازی کرد.

۴. صرفهجویی در زمان و هزینه

برخلاف روشهای سنتی که نیاز به هزاران ساعت نیروی انسانی دارند، RLPT تنها به دادههای خام نیاز دارد.

یادگیری تقویتی پیش آموزش در عمل

فرض کنید یک مدل زبان یادگیری بزرگ مانند Qwen یا LLaMA قرار است آموزش داده شود. بهجای اینکه صرفاً از روشهای سنتی یادگیری نظارت شده استفاده شود، RLPT به مدل اجازه میدهد که خودش روی دادههای متنی بزرگتر کار کند.

برای مثال:

- مدل بخشی از یک متن دانشگاهی یا مقالهی پژوهشی را میبیند.

- سپس تلاش میکند ادامهی متن را پیشبینی کند.

- اگر موفق شد، پاداش میگیرد.

- اگر اشتباه بود، با آزمون و خطا راه درست را پیدا میکند.

نتیجه این است که مدل بهتدریج توانایی پیشبینی و استدلال خود را بهبود میدهد.

پیوند RLPT با ابزارهای روزمره

شاید از خود بپرسید: این مباحث چه ارتباطی با زندگی روزمره یا حتی ابزارهایی مثل اکسل یا پایتون دارند؟

پاسخ ساده است: در بسیاری از حوزهها، مثل پیشبینی بازار، تحلیل دادههای دانشگاهی، یا حتی هوشمندسازی نرمافزارهای کامپیوتری، نیاز داریم مدلها دقیقتر و سریعتر تصمیم بگیرند. RLPT میتواند به ساخت مدلهای هوشمندتر کمک کند.

- در پایتون: پژوهشگران میتوانند با نوشتن کدهای ساده، نسخههای کوچک RLPT را تست کنند.

- در اکسل: تحلیلگران داده میتوانند خروجیهای مدلهای RLPT را در قالب جدول بررسی کنند.

- در دانشگاهها: دانشجویان علوم کامپیوتر و هوش مصنوعی میتوانند این روش را بهعنوان یک پژوهش نوین مطالعه کنند.

مقایسه RLPT با روشهای دیگر

- یادگیری نظارت شده: نیازمند دادههای برچسبخورده و محدود است.

- RLHF (یادگیری تقویتی با بازخورد انسانی): کیفیت خوبی دارد اما پرهزینه است.

- RLPT (یادگیری تقویتی پیش آموزش): بدون نیاز به برچسب انسانی، سریع، مقیاسپذیر و بهینه.

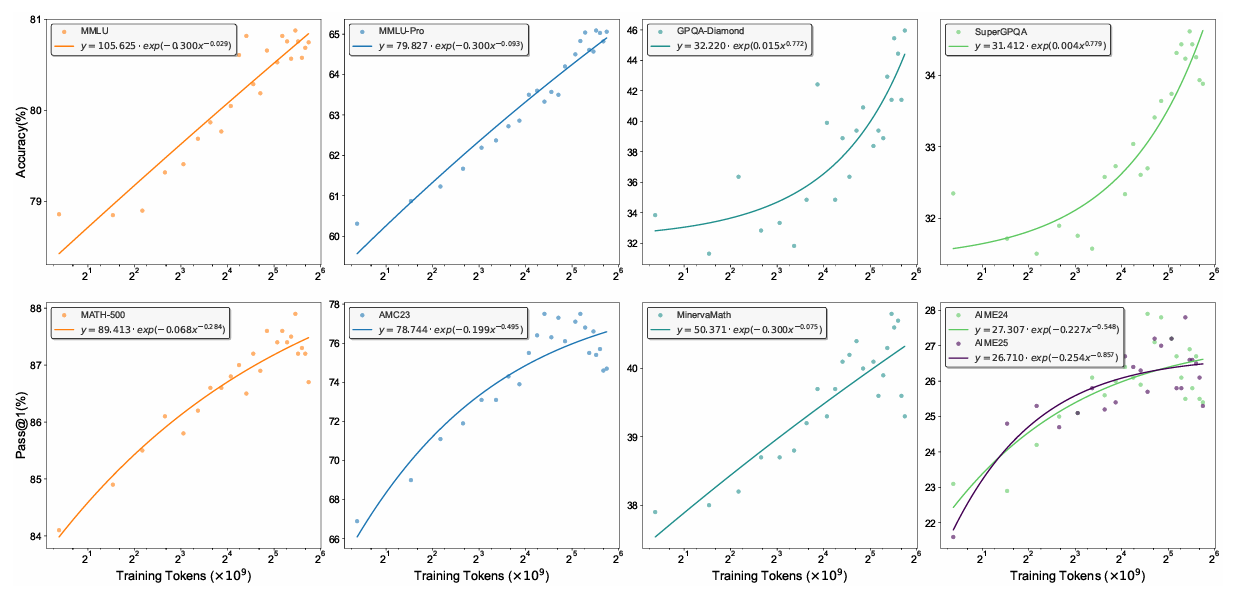

شکل2: مقایسه مقیاس بندی عملکرد RLPT در معیارهای مختلف با توجه به توکن های آموزشی

بهترین روش یادگیری زبان با کمک RLPT

جالب است بدانید که روشهای جدید مثل RLPT نهتنها در هوش مصنوعی، بلکه حتی در آموزش زبان هم الهامبخش شدهاند. همانطور که یک دانشآموز با آزمون و خطا زبان یاد میگیرد و هر بار اشتباه خود را اصلاح میکند، مدلهای هوش مصنوعی هم با روش یادگیری تقویتی پیش آموزش بهمرور زبان و منطق را بهتر میفهمند.

جمعبندی

یادگیری تقویتی پیش آموزش یا RLPT، یک رویکرد نوین در دنیای یادگیری ماشین و یادگیری عمیق است که میتواند آیندهی هوش مصنوعی را تغییر دهد. این روش به مدلها اجازه میدهد از دادههای خام و بدون برچسب استفاده کنند، با آزمون و خطا یاد بگیرند و در نهایت به مدلهایی هوشمند و قدرتمند تبدیل شوند.

اگر به دنبال بهترین روش یادگیری زبان برای ماشینها باشید یا حتی اگر علاقهمند به پژوهشهای یادگیری تقویتی در سطح دانشگاهی هستید، RLPT یک گزینهی بسیار جذاب است.

در نهایت میتوان گفت: آیندهی مدلهای زبان یادگیری بزرگ بدون شک به سمت روشهایی مانند RLPT پیش میرود؛ زیرا این روشها هم بهینهسازی را امکانپذیر میکنند، هم مقیاسبندی را سادهتر میسازند، و هم مسیر را برای نسل جدیدی از مدلهای هوشمند هموار میکنند.

بسیار عالی تشکر از مطالب خیلی مفید بود.