یادگیری بدون آموزش ICL

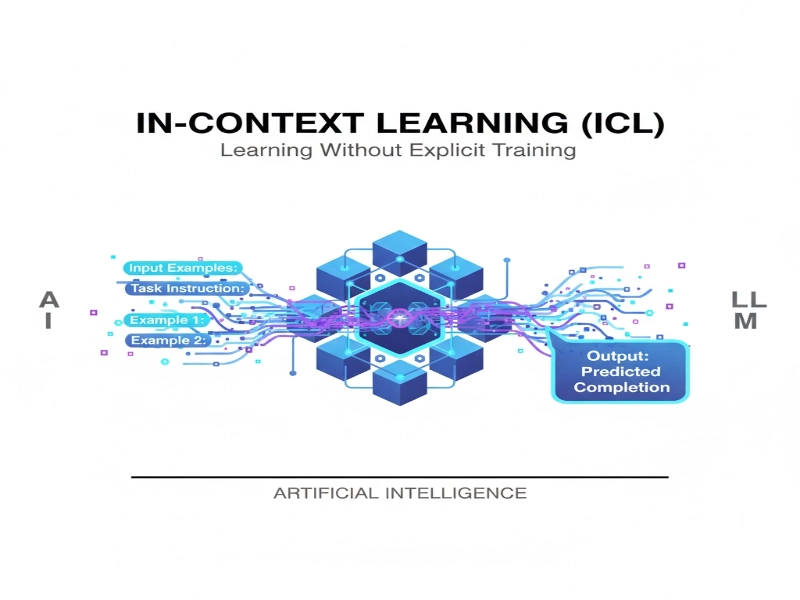

یادگیری بدون آموزش ICL یا همان In-Context Learning یکی از جذابترین مفاهیم دنیای جدید یادگیری ماشین و هوش مصنوعی است. آیا تا به حال شنیدهاید که یک مدل هوشمند میتواند فقط با دیدن چند مثال درون یک پرامپت (Prompt) الگوهای تازهای را یاد بگیرد، بدون اینکه نیازی به تغییر وزنها(پارامتر های داخلی) یا آموزش مجدد داشته باشد، دقیقاً دارید دربارهی همین موضوع صحبت میکنید: یادگیری داخل متن یا همان یادگیری بدون آموزش.

در این مقاله سایت، میخواهیم با زبانی ساده و قابل فهم، حتی برای کسانی که برنامهنویس یا دانشجوی کامپیوتر نیستند، توضیح دهیم یادگیری بدون آموزش مدل یادگیری زبان چیست، چرا مهم است، چه ارتباطی با مدلهای زبان یادگیری بزرگ (LLM) دارد و چطور میتواند آیندهی یادگیری عمیق و الگوریتمهای یادگیری را تغییر دهد.

یادگیری بدون آموزش چیست؟

در یادگیری سنتی یا همان یادگیری نظارت شده (Supervised Learning)، ما یک مدل داریم که با دادههای آموزشی زیاد مثل تصاویر، متن یا اعداد تغذیه میشود. سپس این مدل با الگوریتمهای یادگیری مثل گرادیان نزولی (Gradient Descent) وزن(پارامتر)های داخلیاش را تغییر میدهد تا بتواند الگوها را بهتر یاد بگیرد.

اما در یادگیری بدون آموزش ICL، ماجرا فرق میکند. در اینجا مدل وزنهایش را تغییر نمیدهد. بلکه وقتی شما یک کوئری کاربر به همراه چند مثال ورودی–خروجی به آن میدهید، مدل داخل همان پرامپت یاد میگیرد. یعنی همانجا در لحظه، بدون آموزش مجدد.

مثال ساده: فرض کنید در مدل فرد و زوج اعداد را با شکل جدید بگوییم:

2 ↔ *

3 ↔ #

4 ↔ *

سپس در انتها از او بپرسیم که حالا بنظرت 5 چی میشه؟ مدل بهصورت هوشمند جواب میدهد: «#». در حالی که ما مدل را برای این کار آموزش ندادهایم! این یعنی توانایی شگفتانگیز یادگیری داخل متن ICL; اینجا بکار میرود که خود مدل از متن وارد شده توسط کاربر شروع به یادگیری میکند و متناسب با همان به آن اهمیت میدهد نسبت به چیزهایی که خودش قبلا آموزش دیده.

چرا یادگیری داخل متن مهم است؟

یادگیری داخل متن یا همان یادگیری بدون آموزش ICL یکی از قابلیتهای ویژه در مدلهای زبانی بزرگ (LLMs) است. این روش به مدل اجازه میدهد تنها با چند مثال ساده در متن، الگوهای جدید را درک کند؛ بدون این که نیاز به آموزش دوباره داشته باشد. اهمیت In-Context Learning را میتوان در چهار جنبه زیر بررسی کرد:

1. سرعت بالا یادگیری:

نیازی نیست مدل دوباره آموزش ببیند. کافی است چند مثال به آن بدهید. گویی که با خواهر یا برادر کوچکتر خود چت میکنید و چیزی به او یاد میدهید. یکی از مهمترین مزایای یادگیری داخل متن، سرعت بسیار بالا در سازگاری با وظایف جدید است. در روشهای سنتی یادگیری ماشین، اگر میخواستیم مدلی را برای کاری تازه آماده کنیم، باید دوباره آن را آموزش میدادیم؛ فرایندی که ممکن بود روزها یا حتی هفتهها طول بکشد. اما در یادگیری بدون آموزش ICL، کافی است چند مثال کوچک به مدل داده شود تا همان لحظه یاد بگیرد. این ویژگی بهویژه در کاربردهای روزمره مثل تحلیل سریع داده در اکسل، نوشتن اسکریپت پایتون یا پاسخ به پرسشهای فوری کاربران بسیار ارزشمند است.

2. انعطافپذیری بدون آموزش:

مدل میتواند بدون ریزتنظیم (Fine-tuning) کارهای جدید را یاد بگیرد. اینجا بجای کد نویسی داریم فقط چت میکنیم. انعطافپذیری بالا باعث میشود یادگیری بدون آموزش ICL در شرایط مختلف و برای نیازهای متفاوت قابل استفاده باشد. مدلها میتوانند بسته به کوئری کاربر، خود را با مثالهایی که در متن قرار داده میشود هماهنگ کنند. مثلاً:

- امروز میتواند برای ترجمه متن استفاده شود.

- فردا همان مدل میتواند برای تولید محتوا یا تحلیل داده به کار گرفته شود.

این انعطاف باعث میشود کاربران نیازی به داشتن چندین مدل جداگانه برای هر وظیفه نداشته باشند.

3. هوشمند بودن:

این توانایی یکی از قابلیتهای نوظهور (Emergent Capability) در مدلهای زبان یادگیری بزرگ (LLMs) مثل GPT است. شما میتوانید حتی با زبان محاوره ای هم آموزش بدهید. یادگیری داخل متن جلوهای از هوشمند بودن واقعی مدلهای زبانی است. مدل نهتنها میتواند الگوهای موجود در دادههای آموزشی خود را به یاد بیاورد، بلکه با چند نمونه تازه میتواند استدلال کند و راهحلهای جدیدی بسازد. به بیان سادهتر، In-Context Learning نشان میدهد که مدلها توانایی «فهمیدن در لحظه» را دارند؛ یعنی شبیه یک دانشجو که فقط با دیدن چند مثال ساده میتواند مسئلهای جدید را حل کند. این همان چیزی است که باعث شده پژوهشگران، یادگیری بدون آموزش ICL را یکی از پدیدههای نوظهور (emergent phenomena) در هوش مصنوعی بدانند.

4. مقیاسپذیری:

هر چه مدلها بزرگتر شوند، قدرت In-Context Learning در آنها بیشتر دیده میشود. مقیاسپذیری (Scalability) در دنیای هوش مصنوعی بسیار مهم است. وقتی یک مدل بتواند بدون آموزش مجدد برای وظایف مختلف استفاده شود، بهراحتی میتوان آن را در مقیاسهای بزرگ به کار گرفت. این یعنی:

- همان مدل زبانی بزرگ (LLM) میتواند برای صدها وظیفهی مختلف در دانشگاه، صنعت یا حتی کسبوکارها به کار گرفته شود.

- دیگر نیازی به هزینههای سنگین آموزش و بهینهسازی جداگانه برای هر کاربرد نیست.

در نتیجه، سازمانها و شرکتها میتوانند با یک مدل و یادگیری بدون آموزش ICL، طیف وسیعی از نیازهای خود را پوشش دهند و سریعتر رشد کنند.

مکانیزم پنهان: آپدیت ضمنی وزنها

مقالهای که اخیراً در سایت arXiv درباره یادگیری بدون آموزش ICL منتشر شده، توضیح جالبی ارائه میدهد. نویسندگان نشان میدهند که یک بلاک ترنسفورمر (Transformer Block) که شامل self-attention (خودتوجهی) و یک MLP است، میتواند در زمان پردازش متن، یک بهروزرسانی ضمنی وزنها (Implicit Weight Update) شبیهسازی کند.

به زبان ساده، وقتی مدل مثالها را در پرامپت میبیند، ترکیب self-attention و MLP کاری میکند که انگار وزنهای مدل تغییر کردهاند، در حالی که در واقع هیچ آموزشی انجام نشده. این تغییر معمولاً یک آپدیت کمرتبه (Low-rank Update) است؛ یعنی تغییری ساده و ساختاریافته در محاسبات.

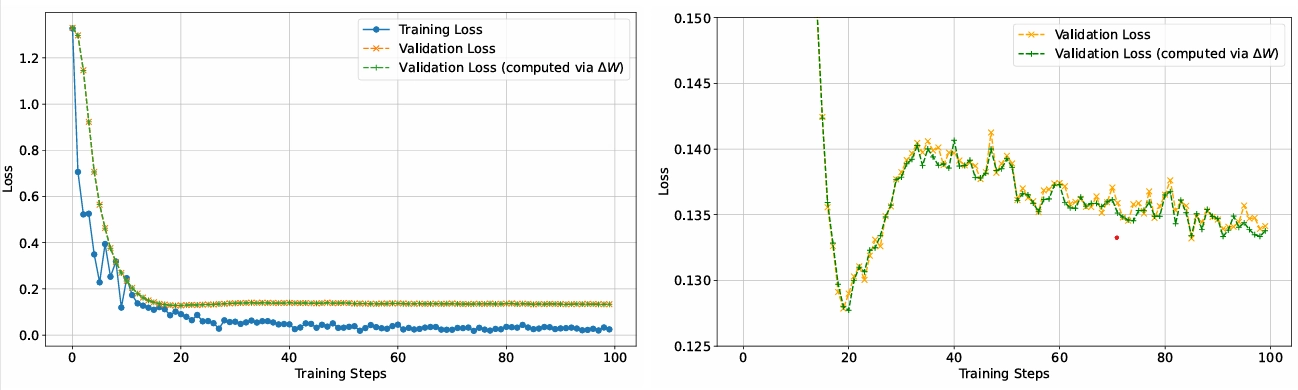

در این نمودار منحنیهای خطای آموزش و اعتبارسنجی مقایسه شدهاند. خطای اعتبارسنجی به دو روش محاسبه شده: یکبار با وزنهای اصلی مدل و یکبار با وزنهای اصلاحشده ∆W. نتیجه نشان میدهد که In-Context Learning میتواند نقش نوعی بهینهسازی ضمنی وزنها را ایفا کند.

مقایسهٔ یادگیری سنتی و یادگیری بدون آموزش (ICL)

جدول زیر تفاوتهای اصلی بین روش سنتی (نظارتشده) و یادگیری بدون آموزش ICL (In-Context Learning) را به زبان ساده نشان میدهد.

| ویژگی | یادگیری سنتی (نظارتشده) | یادگیری بدون آموزش (ICL) |

|---|---|---|

| تغییر وزنها | دارد — پارامترها در فرایند آموزش با الگوریتمهایی مثل گرادیان نزولی تغییر میکنند. | ندارد — یادگیری در لحظه و درون پرامپت اتفاق میافتد بدون بهروزرسانی پارامترها. |

| نیاز به دادهٔ آموزشی | معمولاً حجم زیاد دادهٔ برچسبخورده لازم است. | فقط چند مثال در پرامپت کافی است؛ نیازی به مجموعهٔ آموزشی بزرگ نیست. |

| سرعت | کندتر — آموزش معمولاً زمانبر و پرهزینه است. | سریع — پاسخهای سازگار با چند مثال در همان لحظه تولید میشود. |

| انعطافپذیری / بسطپذیری | برای هر وظیفه ممکن است نیاز به ریزتنظیم (Fine-tuning) داشته باشد. | وظایف جدید را بدون ریزتنظیم میپذیرد و سریع شخصیسازی میشود. |

| پیچیدگی مکانیزم | واضح و براساس بهروزرسانی صریح وزنها (الگوریتمهای شناختهشده). | مکانیزم پنهان است — تحقیقات نشان میدهد تعامل attention و MLP میتواند آپدیتهای ضمنی کمرتبه تولید کند. |

| مناسب برای | پروژههای پایدار با دادههای ساختاریافته و نیاز به تعمیم دقیق. | نمونهسازی سریع، تعامل با کوئری کاربر، و شخصیسازی لحظهای. |

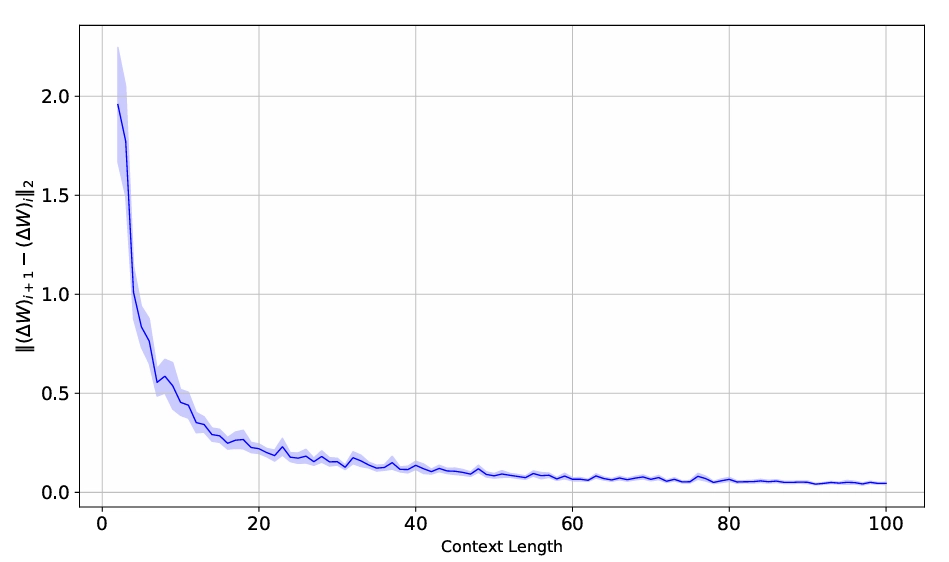

نمودار نشاندهنده همگرایی وزنهای اصلاحشده (∆W) است. با افزایش طول context، اختلاف i(∆W)i+1 − (∆W)i∥2∥ کاهش مییابد و تغییرات وزنها تقریباً به صفر میل میکند؛ یعنی مدل پس از پردازش کافی، به یک نقطه تعادل در بهروزرسانی ضمنی وزنها میرسد. به عبارتی هرچه متن بیشتری به مدل داده شود، تغییرات درونی آن کمتر شده و در نهایت به حالت پایدار میرسد.

مثال کاربردهای یادگیری بدون آموزش ICL

پشتیبانی دانشگاهی: یک دانشجو میتواند سوالات ریاضی را در پرامپت وارد کند و مدل در لحظه یاد بگیرد چه الگوریتمی برای حل استفاده کند.

کار با دادهها در اکسل و پایتون: فرض کنید شما دادههای فروش دارید. با چند مثال در پرامپت، مدل میتواند در همان لحظه تحلیل کند و خروجی بهینه ارائه دهد.

- یادگیری ماشین و یادگیری عمیق: پژوهشگران میتوانند از یادگیری بدون آموزش ICL برای آزمایش سریع ایدهها بدون آموزش دوباره استفاده کنند.

ارتباط با کاربر هوشمند: سیستمهای چت هوش مصنوعی میتوانند فقط با چند مثال از کاربر، پاسخها را شخصیسازی کنند.

آینده یادگیری بدون آموزش ICL

- بهینهسازی مدلها: با درک بهتر از آپدیتهای ضمنی، میتوان مدلهای کارآمدتری ساخت.

مقیاسبندی (Scaling): هر چه مدلهای زبانی بزرگتر شوند، قدرت In-Context Learning بیشتر نمایان میشود.

- هوش مصنوعی عمومی (AGI): توانایی یادگیری در لحظه بدون آموزش مجدد، یکی از کلیدهای رسیدن به هوش مصنوعی هوشمند و عمومی است.

الگوریتمهای یادگیری جدید: محققان در حال بررسی هستند که آیا میتوان الگوریتمهای الهامگرفته از یادگیری بدون آموزش ICL برای کاربردهای دیگر در کامپیوتر و یادگیری عمیق طراحی کرد.

جمعبندی

یادگیری بدون آموزش ICL به ما نشان میدهد که مدلهای زبان یادگیری بزرگ (LLM) فراتر از آنچه فکر میکردیم هوشمند هستند. آنها میتوانند بدون تغییر وزنها و فقط با چند مثال در پرامپت، الگوهای جدید یاد بگیرند. این موضوع نه تنها درک ما از یادگیری ماشین و یادگیری عمیق را تغییر میدهد، بلکه مسیر جدیدی برای آیندهی هوش مصنوعی هوشمند باز میکند. حتی مسیرهایی بدون دخالت انسان ها.

اگر امروز در دنیای دانشگاه، برنامهنویسی پایتون یا حتی کارهای ساده با اکسل و غیره فعالیت دارید، دیر یا زود با یادگیری بدون آموزش ICL روبهرو میشوید. این پدیده یکی از مهمترین تحولات در الگوریتمهای یادگیری است که هم در مقیاس بزرگ و هم در کاربردهای روزمره اثرگذار خواهد بود.

برای مطالعه بیشتر در این حوزه و مطالب مرتبط به مقاله یادگیری تقویتی روی داده های پیش از آموزش RLPT و همچنین BDH جوجه اژدها پل بین معماری ترنسفورمر و زیست مغزی نیز سر بزنید.

بدون دیدگاه